Cari amici astrofili, come sapete bene mi piace cercare sempre di proporre qualcosa di un po’ particolare, in questo blog. E nella nostra, grande, passione non mancano certo gli spazi per ogni tipo di tecnica e di modalità di ripresa! Ma poi ci sono alcune tecniche di ripresa che mostrano la loro particolarità proprio fondandosi sulla semplicità della strumentazione coinvolta.

Siamo nell’era delle CMOS raffreddate, in cui sensori di grandi prestazioni, capaci di digitalizzazione on-chip del segnale e dotati di risoluzioni pazzesche sono davvero alla portata di tutti. Eppure, una delle tecniche di ripresa astronomica più diffuse, nonostante tutto, coinvolge l’uso delle tradizionali DSLR; spesso non di fascia top, prese magari usate, con 100000 scatti all’attivo, magari anche un po’ maltrattate, ma perfette per poter essere portate fuori a freddo e umidità notturne o moddate senza rimpianti.

Ebbene, in questo caso andiamo ancora di più alla radice della fotografia digitale, e puntiamo su un sensore assolutamente diffuso (anche io ho avuto una camera come questa) come quello della Nikon D5100, un APS-C dotato di una ragionevole (anche se non straordinaria) sensibilità alle basse luci; per di più rigorosamente appartenente ad una DSLR NON modificata e anche senza l’uso di alcun tipo di filtro!!!

Il nostro amico Luca Ghiglino fa un uso davvero intensivo, di questa camera, in combinato con un OTA Newton 200/800 Skywatcher, con il quale ha ottenuto risultati davvero notevoli.

Qui sotto il racconto che ha gentilmente voluto farci della sua esperienza.

Dando un segnale per tutti: avere strumentazioni incredibilmente avanzate non è il solo modo per ottenere eccellenti risultati.

Buona lettura a tutti.

LUCA ZANCHETTA – TELESKOP SERVICE ITALIA

Utilizzo di una fotocamera reflex non modificata nella fotografia astronomica di base

di Luca Ghiglino

Luca di TS Italia mi ha chiesto di scrivere un articolo sull’utilizzo di una semplice reflex non modificata (una Nikon D5100 che uso da anni nella fotografia tradizionale) applicato alla fotografia astronomica, senza l’uso di nessun tipo di filtro.

Il mio setup è composto da un Newton F4 (Skywatcher Widephoto 200/800) su montatura NEQ6 con (o senza) telescopio di guida. Il tutto è connesso al portatile, con il programma Sky Chart per muovermi e imparare a conoscere il cielo e PHD Guiding nel caso in cui sia necessaria l’autoguida (software entrambe scaricabili gratuitamente dai rispettivi siti).

Il corpo macchina della Nikon viene raccordato al focheggiatore con un semplice anello T2 e un correttore di coma Baader che riduce l’allungamento delle stelle ai bordi del campo inquadrato (se l’oggetto è contenuto nella parte centrale del campo, quest’ultimo può essere un accessorio non indispensabile). Ovviamente il risultato finale è sempre rapportato alle condizioni del cielo, al corretto allineamento/collimazione del telescopio e al tempo che si è disposti a passare su un determinato oggetto.

Fig 1

Il setup utilizzato

La modalità di scatto della Nikon è manuale, le ISO sono solitamente impostate a 800, il bilanciamento del bianco è impostato su luce solare e gli scatti sono in RAW, formato che torna utile nella successiva elaborazione.

Una volta in posizione, con l’inseguimento attivo, scatto alcune foto di prova centrando l’oggetto e ruotando la macchina sul suo asse per riprenderlo il più possibile nella sua interezza. Gli scatti di prova sono utili anche per capire se stiamo saturando troppo l’immagine in relazione al tempo di posa impostato. Per oggetti luminosi come stelle e ammassi di solito bastano 30” di esposizione per ogni scatto (in questo caso l’autoguida non è necessaria) e per oggetti flebili come galassie e nebulose, considerando che non uso nessun tipo di filtro, non supero i 180” di esposizione, con autoguida.

Ricordiamoci che foto troppo saturate, con fondo cielo troppo luminoso, sono da scartare perché non riescono a contrastare l’oggetto, mentre quelle poco saturate raccolgono poco segnale e quindi meno dettagli: la visualizzazione sullo schermo LCD dell’istogramma della foto appena scattata, aiuta a mantenersi con la parte iniziale dello stesso poco più in basso del bordo a sinistra del grafico, trovando così il tempo di esposizione ottimale, che ogni sera non è mai uguale e varia in base al seeing e alla location, quest’ultima correlata naturalmente anche all’inquinamento luminoso.

Un altro aspetto fondamentale è la messa a fuoco: adotto la modalità “live-view” in modo da vedere le stelle direttamente sullo schermo LCD. Come riferimento ne prendo una medio/piccola, vado a ingrandirla con lo zoom digitale e mi regolo cercando il punto intermedio tra l’effetto “cerchio” e l’effetto “pallina”: questa per me è la posizione ideale di fuoco, quando la stella diventa puntiforme. Meglio stringere bene le viti di fermo del focheggiatore e quelle di fissaggio, perchè la reflex non è propriamente leggera e la posizione di fuoco potrebbe spostarsi con il movimento graduale del telescopio.

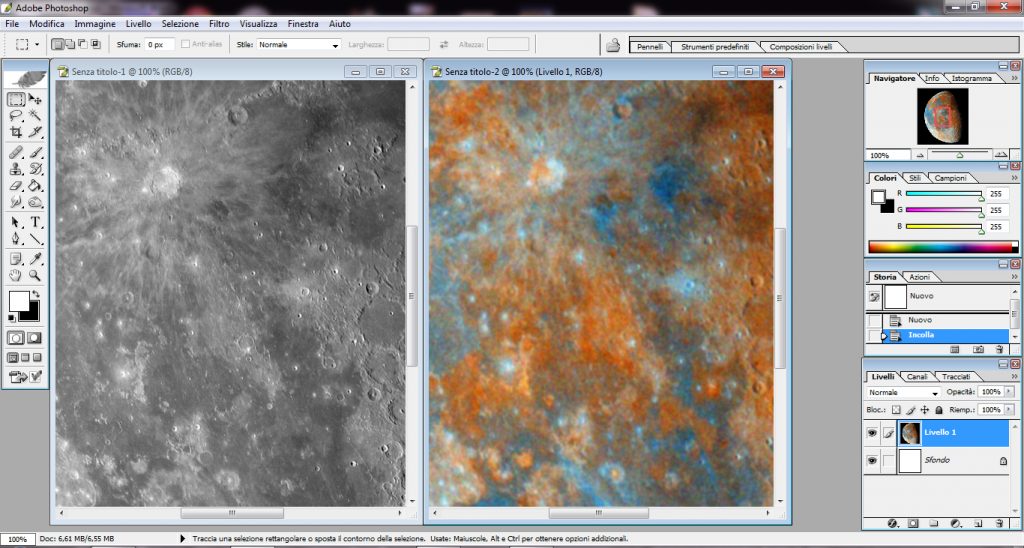

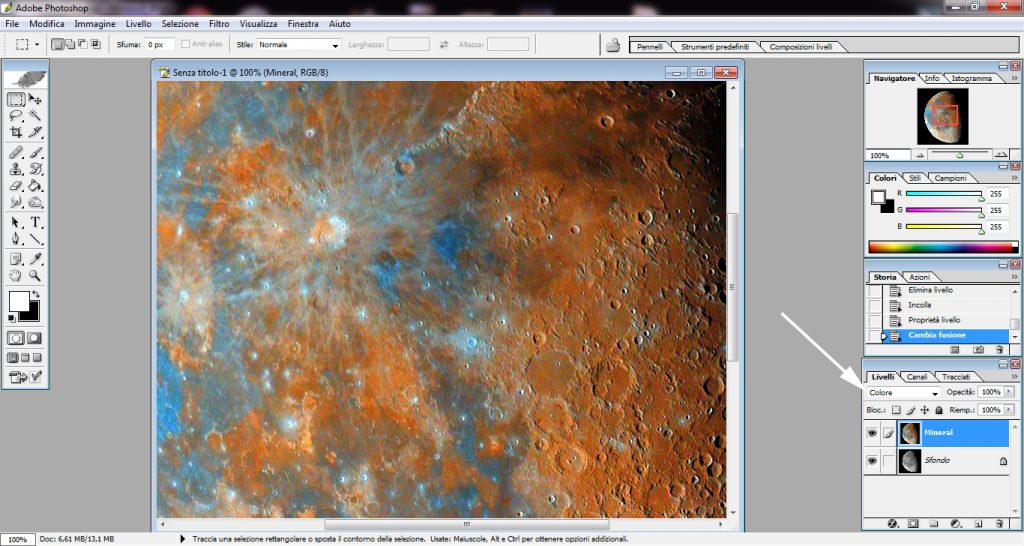

Fig. 2

Uno scatto di prova su lcd della Nikon

Con un semplice telecomando a filo per la programmazione degli scatti multipli, disponibile per Canon/Nikon ad un costo contenuto, imposto il numero di scatti, il tempo di esposizione stabilito con le foto di prova e, cosa molto importante, i secondi di pausa tra uno scatto e l’altro: le reflex, non essendo raffreddate, tendono a scaldare il sensore (con conseguente rumore di fondo in eccesso) quindi per esposizioni più o meno lunghe lascio sempre 40”/60” di pausa tra una foto e l’altra per il raffreddamento.

Alla fine della sessione eseguo sempre gli scatti correttivi, flat e dark, perché, soprattutto i primi, sono fondamentali ai fini della buona qualità del risultato. Le foto vengono poi sovrapposte con il software gratuito Deep Sky Stacker e l’immagine finale elaborata in Photoshop.

Anche se mi considero ancora all’inizio, sono trascorsi ormai due anni a fotografare il cielo con questa camera, e posso dire che, come in ogni campo, nella fotografia astronomica è molto utile iniziare dalle basi. Con una semplice reflex si possono comprendere i principali aspetti e fare pratica con risultati soddisfacenti, in modo da acquisire quella sensibilità ed esperienza che successivamente potremo applicare nell’uso di componenti quali filtri e camere astronomiche più specifiche e performanti, che solo con una consolidata esperienza saremo davvero pronti per poterli gestire.

Seguono alcune foto con i dettagli di scatto.

Un saluto e cieli sereni a tutti.

M13 – Ammasso globulare di Ercole

15 scatti a iso 800 da 120″ di esposizione,

integrazione totale 30 minuti

M81- M82

50 scatti a iso 800 da 180″ di esposizione,

integrazione totale 2 ore e 30 minuti

30 scatti a iso 800 da 40″ ciascuno (senza autoguida),

integrazione totale 20 minuti

NGC6946+NGC6939 – Galassia e ammasso aperto

27 scatti a iso 800 da 30″ di esposizione,

senza autoguida e senza scatti correttivi,

integrazione totale 13 minuti

IC434 in Orione – Nebulosa Testa di Cavallo e Nebulosa Fiamma

35 scatti a iso 800 da 240″ di esposizione (seeing molto buono),

integrazione totale 2 ore e 20 minuti

IC1805 – Nebulosa Cuore

185 scatti a iso 800 da 60″ di esposizione,

integrazione totale circa 3 ore

M42-M43 – Grande Nebulosa di Orione

128 scatti a iso 800 di 80″ di esposizione,

integrazione totale circa 3 ore

M31 – Galassia di Andromeda

31 scatti a iso 1250 da 30″ di esposizione,

20 scatti a iso 800 da 60″ di esposizione,

20 scatti a iso 800 da 150″ di esposizione,

11 scatti a iso 800 da 240″ di esposizione,

integrazione totale circa 2 ore

M33 – Galassia del Triangolo

145 scatti a iso 800 da 100″ di esposizione,

integrazione totale circa 4 ore

M45 – Ammasso delle Pleiadi

110 scatti a iso 800 da 90″ di esposizione,

integrazione totale 2 ore e 43 minuti

NGC6960 – Nebulosa Velo (parte Ovest)

28 scatti a iso 800 da 120″ di esposizione,

integrazione totale 56 minuti

NGC6992-NGC 6995 – Nebulosa Velo (parte Est)

94 scatti a iso 800 da 120″ di esposizione,

integrazione totale 3 ore e 8 minuti