L’astronomia amatoriale è una disciplina affascinante, che ci permette di organizzare viaggi indimenticabili pur rimanendo ben saldi a terra. Possiamo scegliere di scorrazzare tra i pianeti, disegnare i crateri della Luna, oppure possiamo cercare di fare foto o addirittura attività di ricerca che di solito conducono gli astronomi professionisti. Insomma, tra tutte le scienze, e probabilmente tra molte altre attività che potremo mai fare, l’astronomia rappresenta l’emblema della libertà più assoluta, anche perché abbiamo a disposizione miliardi di anni luce di Universo da percorrere a una velocità ben superiore a quella della luce, muovendo semplicemente il nostro telescopio.

L’astronomia pratica, tuttavia, ha un grosso problema, banale quanto fastidioso, soprattutto nelle fredde serate invernali: può essere fatta solo di notte. Di giorno, con l’ingombrante presenza del Sole, possiamo sperare di osservare e fotografare solo lui, il nostro enorme faro cosmico, con strumenti e accorgimenti particolari: un po’ poco, soprattutto conoscendo la bellezza e la vastità che presenti oltre la sua accecante luce. La domanda, allora, può venir spontanea, sebbene in apparenza ingenua: possiamo fare osservazioni e fotografie anche di giorno? Certo: possiamo osservare con un radiotelescopio potente, che non teme neanche le nuvole, oppure inviare nello spazio il nostro setup a far concorrenza al telescopio spaziale Hubble e il problema sarebbe risolto. Facile, no?

In realtà, senza scomodare accorgimenti che oggi suonano come pura fantascienza, si può fare un po’ di astronomia anche di giorno, al di là del Sole. Se la nostra passione sono i pianeti, le foto in alta risoluzione o semplicemente avere nuove sfide da vincere, l’astronomia di giorno diventa un’importante risorsa che potrà farci divertire e ottenere ottimi risultati.

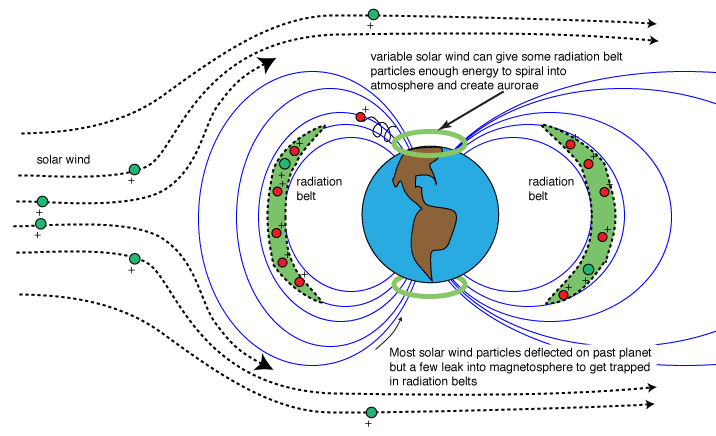

Per convincervi che la mia precedente frase non è il classico delirio che si presenta prima o poi a ogni astrofilo che deve sopportare un interminabile periodo di meteo indecente, cominciamo a chiederci: cos’è che impedisce di vedere le stelle di giorno?La risposta è istintiva: il Sole! Ma siamo sicuri? Perché tutti i telescopi spaziali possono osservare il cielo anche con il Sole sopra l’orizzonte? La luce solare è una condizione necessaria ma non sufficiente a nascondere le stelle di giorno, tanto che nello spazio il cielo appare nero come la pece e si possono vedere le stelle anche con il Sole. La responsabile ultima è la nostra atmosfera: l’aria che respiriamo non è perfettamente trasparente ma intercetta una piccola parte della luce solare e la riflette poi in ogni direzione. Questo fenomeno, conosciuto come diffusione, è il responsabile del nostro cielo chiaro di giorno: le stelle non si vedono a causa dell’enorme inquinamento luminoso prodotto dal Sole, che viene diffuso dalla nostra atmosfera e rende il cielo molto brillante.

Ora possiamo fare un altro passo allora, chiedendoci: c’è modo, restando qui sulla Terra, e senza usare un radiotelescopio, di osservare il cielo di giorno? La risposta è sì, ma in realtà la domanda non è ancora necessaria, perché ci sono già alcuni corpi celesti che possiamo osservare di giorno, anche se a occhio nudo crediamo di non vederli. Prima però, proprio come in un film, mi piace creare un po’ di suspance andando a indagare meglio le ragioni per cui dovremo tirare fuori il telescopio anche di giorno (per la felicità di mogli, compagne, figli e datori di lavoro).

Perché fare foto di giorno

In realtà fare osservazioni di giorno, al di là del Sole, ha molti risvolti interessanti, che voglio riassumere in pochi e sintetici punti, per andare poi al nocciolo della questione:

- Per sfida personale;

- Per il gusto di trovare oggetti che erroneamente reputavamo invisibili con la luce del giorno;

- Perché non abbiamo tempo di notte, o fuori fa freddo quando non c’è il Sole;

- Perché alcuni soggetti danno il meglio di sé, sia in fotografia che in osservazione, di giorno. Mercurio e Venere si osservano e fotografano molto meglio quando sono alti sull’orizzonte rispetto al crepuscolo. La Luna in fase ridotta, che mostra regioni spettacolari come il Mare Crisium, si può osservare e fotografare con soddisfazione solo quando è a poche decine di gradi dal Sole, quindi di giorno, se non vogliamo essere distrutti dalla turbolenza atmosferica alle basse altezze sull’orizzonte, come accade anche per Mercurio e Venere;

- Alcuni fenomeni, come occultazioni, congiunzioni, eclissi dei satelliti di Giove, non sempre capitano di notte: vogliamo farci fermare allora da un po’ di luce solare?

- Chi monitora i pianeti ha necessità di riprenderli e/o osservarli per più tempo possibile, quindi anche di giorno, soprattutto quando la loro separazione è inferiore ai 40° dalla nostra Stella. In queste condizioni, inoltre, i professionisti non possono osservare e molti amatori si dirigono verso altri soggetti. E’ proprio qui che la probabilità di scoprire qualche fenomeno particolare aumenta di molto: una nuova tempesta di sabbia su Marte, una mega tempesta su Saturno, una gigantesca nube di ammoniaca che fa sparire un’intera banda equatoriale di Giove… Sappiamo infatti che la legge di Murphy è impietosa: se qualcosa di spettacolare deve succedere nel cielo, lo farà di certo di giorno. E noi, allora, la aggiriamo osservando anche quando nessuno pensa che si possa fare!

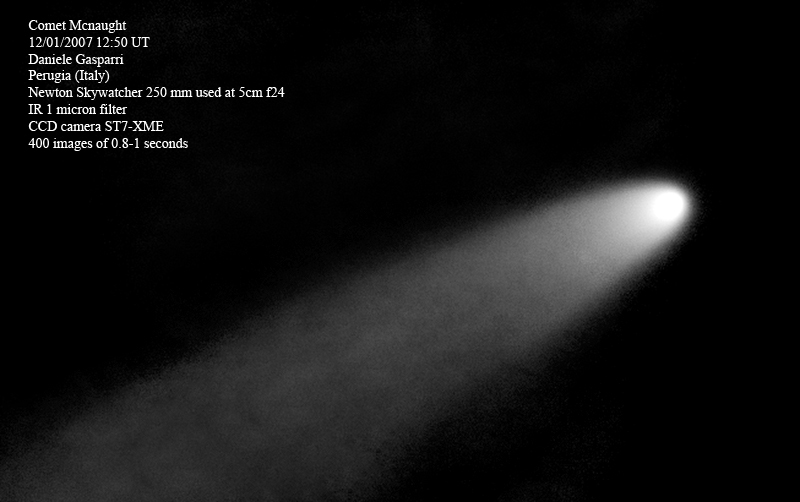

- Sempre per la legge di Murphy, se una grande cometa, con una magnitudine di -7. si rendesse visibile a 15-20 gradi dall’orizzonte e in una posizione dell’eclittica che rendesse impossibile osservarla dal nostro emisfero (in pratica tutte le grandi comete degli ultimi 19 anni!) l’alternativa sarebbe volare in Australia o fare fotografie di giorno. E noi le faremo (anche se un viaggio in Australia è senza dubbio più interessante)!

Insomma, oltre al lato ludico/personale c’è un’oggettiva prospettiva scientifica, che interessa di sicuro gli osservatori e gli astroimager più esperti: osservare di giorno, visto che la nostra tecnologia lo consente, è di certo qualcosa da provare prima o poi, anche se con le dovute precauzioni.

Perché osservare e fotografare di giorno? Ecco un motivo: occultazione Luna-Venere del 16 giugno 2007 alle ore 15 locali. Se avessimo aspettato il calar del Sole ce la saremmo persa!

Luna e Venere, sempre presenti a occhio nudo

A molti sarà di sicuro già capitato di osservare la Luna a occhio nudo, anche di giorno, senza particolari difficoltà. In effetti il nostro satellite si può vedere fino a poche decine di gradi di distanza dal Sole. Osservato al telescopio, soprattutto nelle giornate molto limpide, si mostra già interessante e ricco di particolari.

C’è però un altro corpo celeste che è visibile senza ausilio ottico, in pieno giorno: Venere. Il fatto che non l’abbiamo mai visto non è un indicatore affidabile sulla sua reale osservabilità. Con una magnitudine media di circa -4.5, in effetti, Venere è l’unico oggetto di apparenza stellare che può essere visto a occhio nudo di giorno, a patto che sia ad almeno 20° di distanza dal Sole. Un cielo limpido, che si mostra con una marcata tonalità azzurra, aiuta molto nell’impresa di scovare il pianeta a occhio nudo, ma in realtà la parte più difficile dell’impresa coinvolge il nostro sistema di interpretazione delle immagini, ovvero il cervello. Trovare un punto luminoso su uno sfondo brillante e circa uniforme è un’operazione che il nostro occhio, a livello ottico, è perfettamente in grado di fare, ma il nostro computer biologico fatica a elaborare nella maniera corretta i dati. Il risultato è spesso sorprendente: se non sappiamo bene dove guardare potremmo cercare il pianeta di giorno per ore senza vederlo. Se invece sappiamo dove dirigere il nostro sguardo, con un errore di circa 1-2° al massimo, allora il pianeta diventa evidente perché è sempre piuttosto contrastato rispetto al fondo cielo. All’improvviso, dopo tanto cercare, ci apparirà in quella spessa coperta azzurra un piccolo buco da cui filtra la luce puntiforme del pianeta a noi più vicino:“Come ho fatto a non vederlo prima?” E’ sempre questa la domanda che ci si pone con estrema sorpresa e molta soddisfazione per aver visto una “stella” nel cielo illuminato dal Sole. Per identificarlo con meno difficoltà è sempre opportuno nascondere il Sole dietro un ostacolo naturale o artificiale (una collina, degli alberi, una casa…) e scandagliare bene la zona di cielo in cui dovrebbe trovarsi (aiutiamoci con un software planetario).

Venere di giorno si può rintracciare con facilità anche a occhio nudo, se sappiamo bene dove guardare. Riuscite a trovarlo in questa foto scattata con un cellulare?

Al telescopio, Venere, osservato di giorno, dà il meglio di sé, per due motivi:

- Possiamo ammirarlo quando è molto alto sull’orizzonte, senza aspettare il tramonto o l’alba, quindi, se abbiamo l’accortezza di nascondere il Sole dietro un ostacolo naturale ed evitare che scaldi il tubo ottico, la turbolenza sarà sempre minore e la visione più dettagliata;

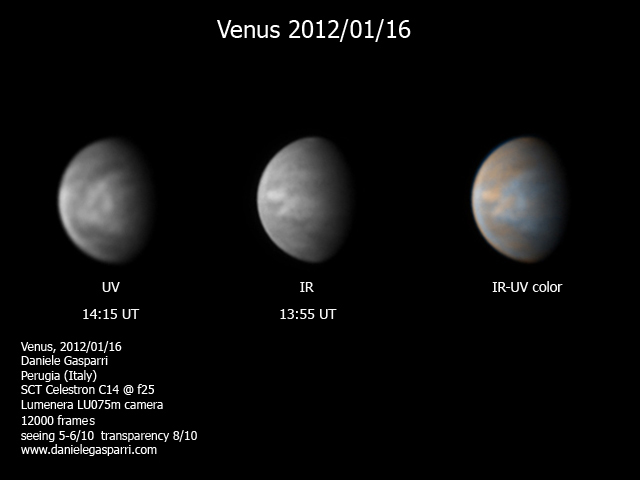

- Il pianeta è molto luminoso. Se lo puntiamo con il cielo già scuro del crepuscolo, la sua luminosità inganna l’esposimetro del nostro sistema visivo, che ce lo mostrerà sempre troppo brillante, come se fosse una fotografia “bruciata”. Il risultato? Perdita di ogni tipo di dettaglio e un certo fastidio nella visione. Di giorno, invece, grazie al contrasto molto più basso tra il fondo cielo e Venere, il cervello applica la giusta esposizione e il pianeta non è mai sovraesposto. L’osservazione è molto più rilassante e spettacolare, perché potremo scorgere con relativa facilità alcune sfumature nella spessa atmosfera venusiana, anche senza l’uso di filtri colorati o grossi strumenti. Personalmente tutte le migliori osservazioni e fotografie di Venere le ho fatte di giorno, tra le 12 e le 16 locali.

Venere mostra molti dettagli, sia in visuale che, soprattutto, in fotografia. Il segreto? Osservare di giorno, quando il pianeta è alto nel cielo.

Mercurio e oltre: a volte meglio di giorno, ma solo per i più esperti

Quanto scriverò da questo punto in poi prevede delle operazioni delicate, soprattutto per il puntamento, che devono essere fatte solo da persone ormai esperte di osservazioni e fotografia. La tecnica, infatti, spesso implica di fare un salto prima sul Sole, con tutti i rischi che ne conseguono se non si usa un filtro solare e molta attenzione. Leggere quindi bene quanto segue, se vogliamo proseguire con il nostro tour del cielo diurno.

Purtroppo a occhio nudo il gioco è già finito: il giro turistico del Cosmo termina con l’emozione e la sfida di trovare Venere, ma con un telescopio possiamo esplorare l’invisibile e fare altre spettacolari osservazioni.

Le particolari condizioni in cui si presenta Venere, ovvero un pianeta che non si allontana mai dal Sole per più di poche decine di gradi, sono ancora più esasperate per Mercurio. Per il più piccolo pianeta del Sistema Solare non abbiamo molta scelta: le osservazioni di giorno sono le UNICHE che danno qualche soddisfazione. E’ inutile cercare di fare i testardi e aspettare anni per trovare un buon seeing e trasparenza all’alba o al tramonto, con il Sole sotto l’orizzonte e il pianeta ben visibile a occhio nudo: non avremo mai una visione nitida come di giorno. Questo vale ancora di più se l’obiettivo è fare foto.

Mercurio di giorno mostra tenui chiaroscuri che non vedremo mai al crepuscolo

Più facile e spettacolare di Mercurio, Marte è un altro soggetto ghiotto per fare osservazioni. Quando la sua separazione è maggiore di 60° dal Sole, il pianeta rosso ha ancora una discreta luminosità e diametro angolare per mostrare dettagli. Grazie alla sua colorazione rossastra, che contrasta in modo netto con l’azzurro del cielo,  l’osservazione di Marte di giorno può essere spettacolare, soprattutto quando il Sole si sta avviando verso il tramonto (o poco dopo l’alba). In un certo senso, per chi non è abituato a osservare i pianeti, l’esperienza diurna migliora la visione perché diminuisce i contrasti e impedisce, proprio come accade per Venere, di avere un’immagine troppo luminosa, quindi sovraesposta e povera di particolari. Il rapido tempo di esposizione del nostro occhio, inoltre, ha anche il potere di congelare il seeing molto meglio rispetto a quanto accade di notte, con la visione notturna e un tempo di esposizione che viene incrementato automaticamente dal nostro cervello. In un certo senso ed entro determinati limiti, di giorno la visione migliora anche a seguito di questo fenomeno, lo stesso per cui gli astroimager planetari tendono a fare esposizioni più brevi possibili per congelare il seeing.

l’osservazione di Marte di giorno può essere spettacolare, soprattutto quando il Sole si sta avviando verso il tramonto (o poco dopo l’alba). In un certo senso, per chi non è abituato a osservare i pianeti, l’esperienza diurna migliora la visione perché diminuisce i contrasti e impedisce, proprio come accade per Venere, di avere un’immagine troppo luminosa, quindi sovraesposta e povera di particolari. Il rapido tempo di esposizione del nostro occhio, inoltre, ha anche il potere di congelare il seeing molto meglio rispetto a quanto accade di notte, con la visione notturna e un tempo di esposizione che viene incrementato automaticamente dal nostro cervello. In un certo senso ed entro determinati limiti, di giorno la visione migliora anche a seguito di questo fenomeno, lo stesso per cui gli astroimager planetari tendono a fare esposizioni più brevi possibili per congelare il seeing.

Con Giove iniziamo invece ad avere qualche difficoltà. Visibile solo oltre i 45° di elongazione, si presenta spesso come un disco quasi trasparente, ma ricco comunque di contrasti, anche se non riusciremo a vedere i più minuti dettagli della sua atmosfera. Meglio non esagerare con gli ingrandimenti, almeno all’inizio, per non perderlo tra la luce del cielo.

Per Saturno, invece, le cose cambiano e trovarlo rappresenta quasi una sfida, che è facile da vincere con il pianeta oltre i 60° di separazione dal Sole, un cielo molto trasparente e la nostra stella prossima all’orizzonte. Anche in questo caso meglio iniziare con ingrandimenti modesti per trovarlo: circa 50-100X al massimo e poi, se serve, aumentarli (di poco).

Urano e, ancora peggio, Nettuno, dovrebbero essere off limits, ma non si sa mai: con un cielo limpido di montagna, una separazione di almeno 90°, un filtro polarizzatore e un buon occhio, potremo riuscire a scorgere Urano: nessuna speranza, invece, per Nettuno.

Se vogliamo andare oltre i pianeti, possiamo fare un bel tour delle stelle brillanti: snobbate di notte perché poco interessanti (a ragione), di giorno diventano delle gemme da scovare in un mare d’azzurro, come un prezioso tesoro. Ecco allora che non avremo alcun problema nel puntare Sirio, Capella, Altair, Deneb, Vega, Betelgeuse, Antares e Aldebaran. Unica richiesta: cielo terso e almeno 45° di separazione dal Sole!

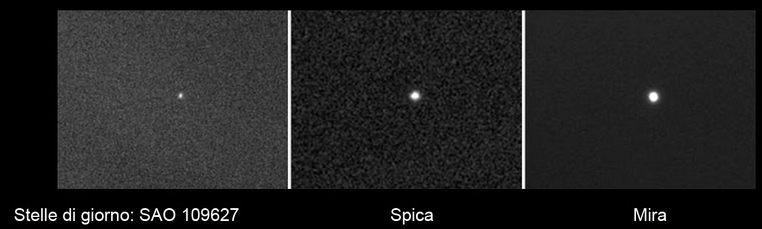

Le stelle si possono vedere anche di giorno! Ma è in fotografia che le cose migliorano e anche di molto

Come puntare di giorno

Prima di uscire con il Sole alto e cominciare a osservare stelle e pianeti, è meglio dare qualche consiglio utile per fare una cosa che di notte è semplice, ma di giorno un po’ meno: a parte la Luna e Venere, nessun altro oggetto si vede a occhio nudo, spesso nemmeno con un piccolo cercatore, quindi: come facciamo a puntare qualcosa che non possiamo vedere finché non è nel campo dell’oculare? Si potrebbe dire: con il puntamento automatico! La risposta è sì, ma con qualche differenza rispetto alla notte. Di giorno, infatti, non possiamo fare l’allineamento della montatura, perché le stelle non si vedono: come fare?

Semplice: dobbiamo connettere la nostra montatura al computer, bypassando la pulsantiera e interfacciandola con un software planetario, come Cartes du ciel. Grazie ai driver Ascom, questa soluzione è abbastanza semplice e molti fotografi già la usano per curare le sessioni di ripresa notturna. Controllando la montatura con il planetario possiamo fare una cosa che molte pulsantiere non permettono: puntare un oggetto celeste ben visibile, sincronizzarla sulle sue coordinate e poi spostarci nella direzione in cui vogliamo osservare l’invisibile.

L’unico oggetto celeste sempre presente, a parte qualche volta la Luna, è il Sole ma è anche il più pericoloso. Per puntare tutti gli altri corpi celesti di giorno occorre quindi quasi sempre sincronizzare la nostra montatura sul Sole, puntandolo a mano. Come ben sappiamo, è assolutamente fondamentale evitare che la luce del Sole entri senza essere filtrata nel telescopio e nel cercatore. Quindi, il primo passo da fare è preparare il setup come se dovessimo osservare il Sole: coprire il cercatore e inserire di fronte l’obiettivo del telescopio un filtro solare sicuro, come l’Astrosolar. Puntiamo la nostra stella con il metodo dell’ombra, poi centriamola osservando dall’oculare (con il telescopio che ha il filtro solare ben saldo e sicuro!). Sincronizziamo la montatura e poi diciamo al planetario (o alla pulsantiera, se lo permette) di andare dove vogliamo: Mercurio, Venere, Marte, qualche stella… È importante scegliere soggetti distanti almeno 15 gradi dal chiarore solare per evitare che parte della sua luce entri nello strumento (e per vedere qualcosa!). Una volta che il telescopio si è spostato verso la destinazione, possiamo togliere il filtro solare e scoprire il cercatore. Con una buona vista e un cercatore da almeno 50 mm di diametro, quasi tutti i soggetti (tranne Saturno) dovrebbero essere visibili attraverso le sue lenti, una cosa molto comoda per poter effettuare un preciso centraggio.

Il successo del puntamento dipende in modo critico dal perfetto stazionamento della montatura equatoriale (non confondete lo stazionamento con l’allineamento del GOTO!), che può essere fatto solo di notte. Ecco quindi che sarebbe meglio lasciare il telescopio montato dalla sera prima e pronto anche al nostro tour diurno.

Se vogliamo spostarci verso oggetti molto distanti è meglio andare per piccoli passi: puntiamo prima un corpo celeste luminoso, come Venere, per sincronizzare di nuovo la montatura e poi spostiamoci verso la destinazione: meglio non fare spostamenti superiori a 40 gradi perché il puntamento non sarà mai precisissimo.

Una cosa fondamentale riguarda poi la messa a fuoco: di giorno, anche per oggetti luminosi come Venere, se il telescopio non è già vicino al punto di fuoco potremo non vedere la sagoma sfocata del pianeta, anche se questo è al centro del campo: assicuriamoci quindi di aver fatto una buona messa a fuoco prima sul Sole e di non cambiare oculare, altrimenti dovremo armarci di pazienza e muovere il fuoco fino a trovare l’oggetto, che sarà visibile solo quando saremo quasi al punto di fuoco. Una cosa simile si deve fare se vogliamo fare foto: facciamo il fuoco prima sul Sole e a una focale non troppo elevata (meglio al fuoco diretto), così saremo sicuri che se il corpo celeste verrà puntato lo vedremo.

Qualche consiglio per le riprese fotografiche

Se vogliamo usare il nostro occhio per osservare, dobbiamo accontentarci di scegliere solo le giornate con il cielo più terso, in modo che i contrasti aumentino al punto da garantire osservazioni molto piacevoli, se non migliori rispetto alla notte. Se invece siamo interessati a fare riprese in alta risoluzione, e in generale a capire quanto in profondità si può vedere anche con il Sole sopra l’orizzonte, allora le cose cambiano molto e potremo restare sorpresi di quanto sia possibile fare. Per capire il trucco che c’è alla base di proficue riprese (non più osservazioni ma fotografie!) diurne, dobbiamo riproporre una domanda alla quale non ho ancora dato risposta: c’è modo, restando qui sulla Terra, e senza usare un radiotelescopio, di osservare il cielo di giorno? Fino a questo momento abbiamo visto che non serve nulla per osservare i principali pianeti, né le stelle, perché anche se non li vediamo in modo spettacolare come di notte, questi in realtà ci sono e si possono osservare al telescopio, se non addirittura a occhio nudo. Tuttavia, grazie alla grande sensibilità dei sensori digitali, possiamo davvero fare qualcosa per migliorare di molto la situazione in fotografia.

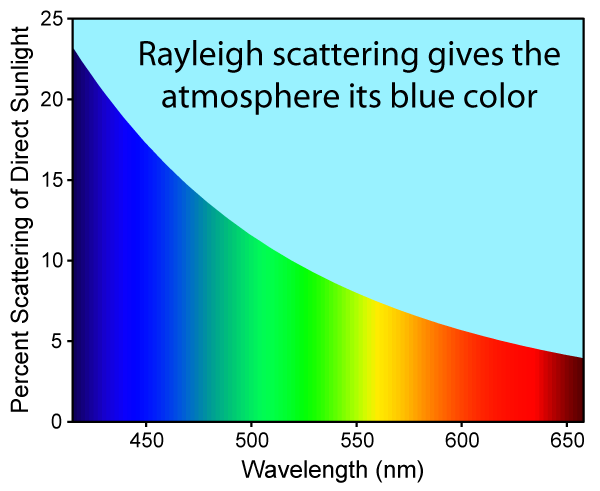

La risposta alla domanda ne prevede allora un’altra: di che colore è il cielo di giorno? Se non abitiamo in pianura Padana, la risposta non ammette eccezioni: azzurro! Cosa vuol dire, a livello più fisico, questo? Che l’aria che respiriamo preferisce diffondere in ogni direzione più la luce azzurra rispetto a quella rossa, visto che quella solare è in realtà bianca e così sarebbe dovuto apparire il cielo se tutti i colori fossero stati diffusi allo stesso modo.

Senza entrare in profonde spiegazioni fisiche, il principio alla base della diffusione della luce da parte di molecole di gas è descritto da un processo chiamato diffusione di Rayleigh. Per i nostri scopi ci basta solo un dato, che è la conferma quantitativa della nostra semplice osservazione sul colore del cielo: la percentuale di luce diffusa è inversamente proporzionale alla quarta potenza della lunghezza d’onda. In parole semplici, all’aumentare della lunghezza d’onda della luce diminuisce drasticamente la percentuale che viene diffusa dall’aria. Ecco quindi che la luce blu viene diffusa circa 16 volte più di quella del vicino infrarosso, che ha una lunghezza d’onda circa doppia e perché per le onde radio giorno o notte non fa alcuna differenza.

La diffusione di Rayleigh in funzione della lunghezza d’onda spiega perché il cielo è azzurro e rappresenta un’interessante scappatoia per fare ottime fotografie diurne.

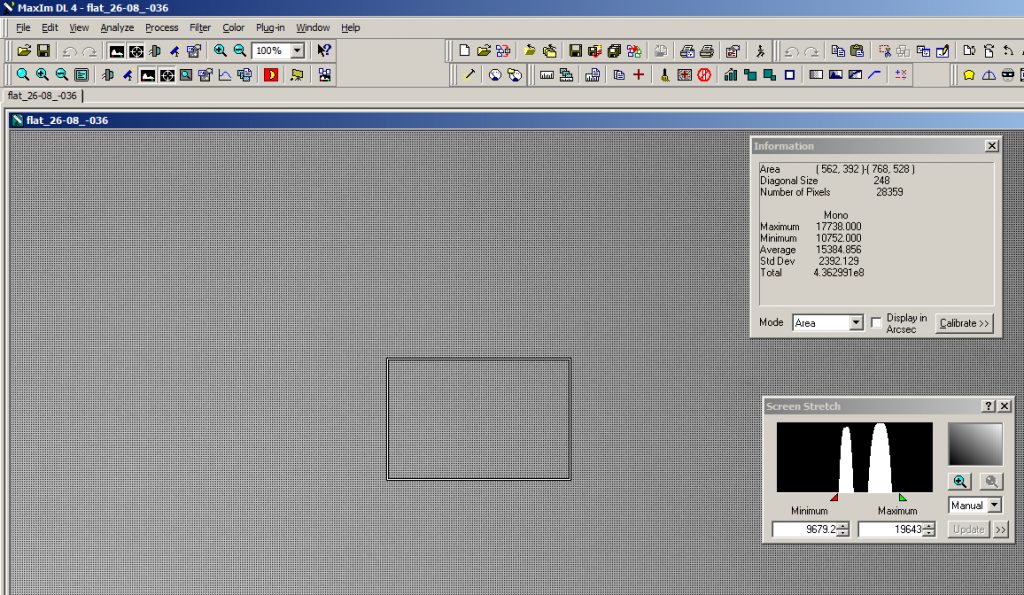

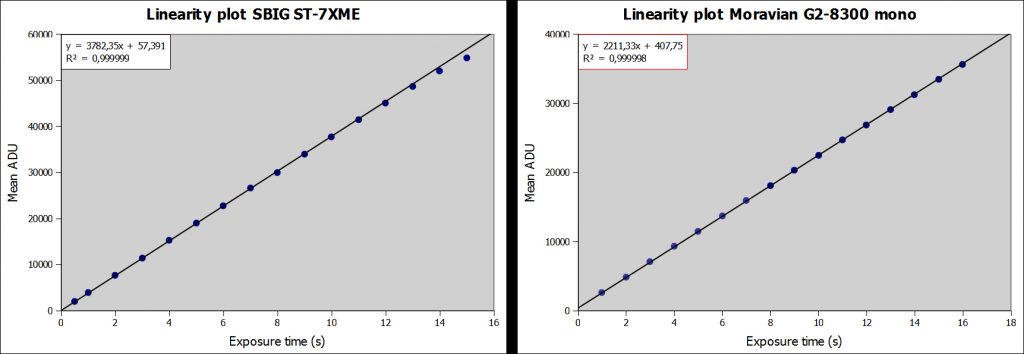

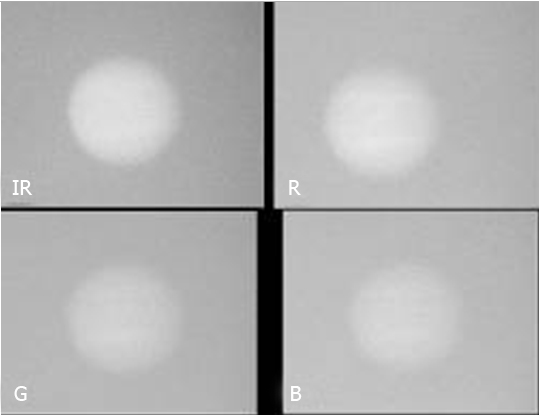

Eureka! Abbiamo trovato il modo per fare fotografie di giorno di soggetti brillanti, come se il Sole quasi non ci fosse: basta usare un filtro passa infrarosso. Più grande è la lunghezza d’onda utilizzata, maggiore sarà il contrasto tra il fondo cielo e il corpo celeste. Volete una prova? Guardate la seguente immagine che ritrae Giove ripreso allo stesso orario con diversi filtri:

All’aumentare della lunghezza d’onda diminuisce la luminosità del fondo cielo e i corpi celesti, come in questo caso Giove, emergono in modo sempre più netto.

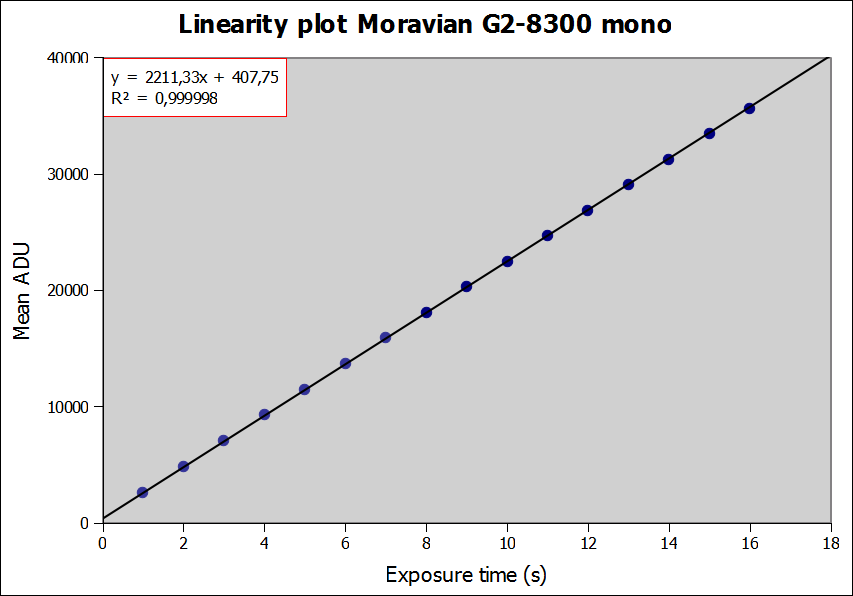

Per poter sfruttare questo trucco ci serve un sensore monocromatico, o al limite una reflex full spectrum, ovvero modificata per renderla sensibile anche all’infrarosso. Questi dispositivi sono sensibili, sia pur in forma ridotta, fino a circa 1100 nm, una regione molto interessante per i nostri scopi. Ottime sono le camere planetarie monocromatiche, spesso usate anche per l’autoguida, come la sempre verde ASI 120MM. Con questi sensori possiamo usare filtri passa infrarosso da 800 e persino 1000 nm (1 micron). In questa zona poco esplorata del vicino infrarosso, il cielo diventa talmente scuro che non solo possiamo fare fotografie alla Luna, Venere, Mercurio, Marte, Giove e Saturno come se fosse notte, ma è addirittura possibile riprendere corpi celesti che nessuno si sarebbe aspettato: i quattro principali satelliti di Giove, ad esempio, tutte le stelle brillanti fino a magnitudine 5-6 e persino oggetti spettacolari come brillanti comete.

Ecco allora che in questo modo, anche con strumenti modesti, a partire da 8-10 centimetri, il cielo diurno mostra tutto ciò che ai nostri occhi apparirebbe ben visibile di notte: fantastico, vero?

In conclusione di un post piuttosto lungo, non mi resta che lanciare un paio di sfide: qual è il corpo celeste più debole che è possibile osservare o fotografare con il Sole sopra l’orizzonte? È possibile ottenere un’immagine di un soggetto deep sky brillante, ad esempio le Pleiadi, o la nebulosa di Orione, di giorno? Per queste imprese i miei consigli sono semplici: 1) Cielo terso come mai si vede dalla pianura; 2) oggetto alto sull’orizzonte almeno 30° e più lontano possibile dal Sole, 3) Sole in prossimità del tramonto o dell’alba.

Riprese diurne estreme: la cometa McNaught del gennaio 2007 a 15 ° dal Sole e con una magnitudine di circa -7, ripresa con un telescopio da 25 cm diaframmato a 5 cm e filtro IR da 1000 nm. D’ora in poi non ci perderemo più un raro evento astronomico solo perché si verifica di giorno, alla faccia della legge di Murphy!

Per il momento i corpi celesti più deboli che ho ripreso sono i satelliti di Giove, che hanno luminosità inferiori a quella delle stelle principali delle Pleiadi o del cuore della nebulosa di Orione: questi due, quindi, sono soggetti ben alla portata della nostra voglia di astronomia anche di giorno. La caccia è aperta!

P.S. Non vale scattare foto deep sky durante un’eclisse totale di Sole!