Nelle osservazioni visuali le immagini vengono ingrandite attraverso gli oculari. Nella fotografia astronomica non ha più senso parlare di ingrandimento, perché al posto dell’occhio si inserisce un sensore digitale senza obiettivo e l’immagine, a rigor di logica, non viene ingrandita. In questi casi si parla di scala dell’immagine o campionamento, le grandezze che determinano “l’ingrandimento” delle immagini digitali.

Il campionamento, o scala dell’immagine, rappresenta la dimensione angolare di cielo che riesce a riprendere un singolo pixel del sensore. Quindi, questo determina anche il più piccolo dettaglio che è possibile, in teoria, risolvere. Una scala dell’immagine di 2”/pix (secondi d’arco su pixel) indica che ogni pixel inquadra una porzione di cielo con lato di 2”. Poiché i pixel sono i punti che formeranno l’immagine digitale, tutto quello che ha dimensioni inferiori a 2” non sarà mai risolto dal sensore. Questo prescinde dalla turbolenza atmosferica e da diametro dello strumento e rappresenta una specie di potenziale. È infatti certo che un’ipotetica scala dell’immagine di 40”/pixel non risolverà mai delle strutture di galassie o nebulose inferiori a questo valore. D’altra parte non è detto, anzi, non è proprio possibile dai nostri cieli, che un campionamento di 0,5”/pixel riesca a mostrarci dettagli di questa dimensione angolare perché saranno rovinati dalla turbolenza atmosferica, anche se usassimo un telescopio in grado di mostrarceli. Il campionamento, quindi, non determina direttamente la risoluzione dell’immagine ma ci permette di capire parametri fondamentali come il campo di ripresa che si ha con una certa accoppiata telescopio – sensore, quindi dà indicazioni su quali soggetti possiamo riprendere al meglio e se saremo limitati o meno dalla turbolenza atmosferica.

Calcolare il campionamento di un’immagine è facile utilizzando la seguente formula:

C = (Dp /F) x 206265,

dove C = campionamento (in secondi d’arco su pixel) , Dp = dimensioni dei pixel del sensore utilizzato e F = focale del telescopio. Dp e F devono avere le stesse unità di misura; 206265 è il fattore di conversione tra radianti e secondi d’arco. Di solito le dimensioni dei pixel sono espresse in micron, mentre quelle della focale in millimetri. Niente paura: un micron corrisponde a 0,001 millimetri.

Campionamento ideale nelle fotografie a lunga esposizione

Un principio, detto criterio di Nyquist, applicato al campo ottico afferma che per sfruttare una determinata risoluzione occorre che il più piccolo dettaglio visibile cada almeno su due pixel adiacenti. Se consideriamo che nel mondo reale è meglio se il più piccolo dettaglio risolvibile cada su almeno 3 pixel, possiamo giungere a importanti conclusioni su quale possa essere il massimo campionamento efficace nella fotografia a lunga esposizione. Se la risoluzione massima a cui possiamo ambire è determinata dalla turbolenza media ed è intorno ai 2,5-3”, a prescindere dal diametro del telescopio, significa che le scale dell’immagine più basse che possiamo usare prima di avere l’effetto delle stelle a pallone e dettagli sempre sfocati sono dell’ordine di 0,8”-1”/pixel. Nelle condizioni medie, di fatto non conviene quasi mai lavorare con scale più piccole di 1”-1,5”/pixel.

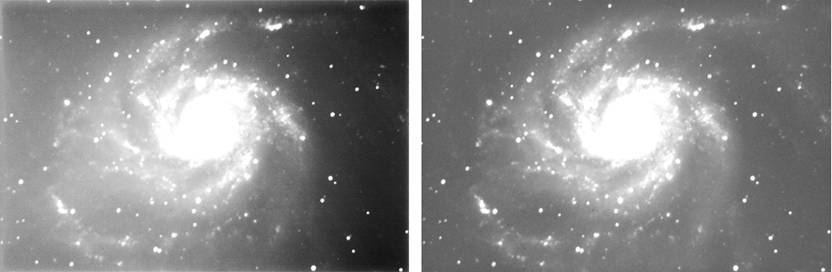

L’effetto più grave di quello che si chiama sottocampionamento, cioè lavorare con scale più grandi, è mostrare stelle così piccole che potrebbero diventare quadrate, perché questa è la forma dei pixel, ma d’altra parte avremo sempre dettagli degli oggetti estesi ben definiti e contrastati, con una profondità in termini di magnitudine ancora ottima. L’effetto di un sovracampionamento, cioè di una scala dell’immagine più bassa di quella limite, è quello di restituire stelle sempre molto grandi e dettagli degli oggetti estesi sfocati e indistinti. Come se non bastasse, un sovracampionamento produce anche una perdita, a volte notevole, di profondità perché la luce si espande su più pixel invece di venir concentrata in una piccola area. Il mio consiglio, quindi, è di non esagerare con la scala dell’immagine e di preferire immagini “meno ingrandite” ma più definite a improbabili zoom che mostrerebbero nient’altro che un campo confuso e molto rumoroso. Questo ragionamento vale sia per le riprese telescopiche, in cui si dà per scontato che il seeing sia il limite alla risoluzione rispetto al diametro dello strumento, che per le fotografie attraverso obiettivi e teleobiettivi, in cui il limite deriva dal potere risolutivo dell’ottica.

Conoscendo il campionamento e il numero di pixel dei lati del sensore, possiamo subito comprendere quanto sarà grande il nostro campo di ripresa e capiremo se sarà possibile riprendere al meglio un’estesa nebulosa o una debole galassia.

Districandosi in questa specie di giungla, potremo costruire un setup più specifico per la tipologia di oggetti che più ci piace. A livello generale e personale, finché useremo delle semplici reflex digitali non vale la pena farsi troppi conti perché tanto per queste non c’è molta scelta a livello di dimensioni dei pixel e del formato del sensore. Quando invece parliamo di CCD (o CMOS) astronomici, che dobbiamo scegliere con molta attenzione, il campionamento che otterremo con il nostro setup rappresenta il punto più importante per la scelta. Sarà infatti inutile, e frustrante, usare un sensore con pixel di 5 micron su un telescopio Schmidt-Cassegrain da 1,5-2 metri di focale, che ci darà un campionamento di 0,70-0,50”/pix e potrebbe venir sfruttato in pieno solo dal deserto di Atacama. Nelle nostre località otterremo sempre stelle a “pallone” e oggetti diffusi molto deboli e rumorosi, tanto da richiedere ore e ore di integrazione per mostrare dettagli interessanti. Un risultato simile si sarebbe ottenuto con una scala dell’immagine anche tre volte superiore e un tempo di integrazione totale dalle 4 alle 9 volte inferiore.

Avere pixel molto piccoli comporta anche una perdita di sensibilità e dinamica, perché un pixel più piccolo raccoglie meno luce e può contenere molti meno elettroni di uno più grande, con la conseguenza che il range dinamico del sensore si può ridurre anche di 5 volte tra pixel da 5,6 micron e da 9 micron. Poiché un sensore astronomico è qualcosa che dovrebbe durare per molti anni e le serate buone si possono contare in un anno sulle dita di due mani, è meglio sceglierne uno che si accoppi in modo perfetto al nostro telescopio. Se ci piacciono primi piani di galassie è meglio ingrandire le immagini in elaborazione che lavorare a una scala piccolissima.

Campionamento ideale nell’imaging in alta risoluzione

Quando parliamo di fotografia in alta risoluzione le cose cambiano drasticamente perché, grazie a pose molto brevi e un enorme numero di frame catturati, possiamo sperare di abbattere il muro eretto dalla turbolenza atmosferica media e spingerci verso la risoluzione teorica dello strumento, fino a un limite di circa 0,3” nelle zone più favorevoli e nelle migliori serate. Quando il seeing collabora, quindi, possiamo impostare la scala dell’immagine sui limiti di risoluzione teorica dello strumento che stiamo utilizzando. Una buona relazione per determinare la risoluzione alle lunghezze d’onda visibili è quella di Dawes:

PR = 120/D

Dove PR = potere risolutivo, in secondi d’arco, e D = diametro del telescopio espresso in millimetri.

Come già detto, affinché il sensore sia in grado di vedere questa risoluzione occorre che questa cada su 3-4 pixel: né molto più, né molto meno. In queste circostanze, allora, il nostro obiettivo sarà quello di lavorare a cavallo del campionamento ottimale, che può essere espresso dalla semplice formula:

Cott= 37/D

Dove D = diametro del telescopio espresso in millimetri e Cott = campionamento ottimale, espresso in secondi d’arco su pixel. Come possiamo vedere dal confronto con la formula di Dawes, cambia di fatto solo il coefficiente numerico, che è inferiore di poco più di tre volte, proprio come abbiamo detto con le parole. Il valore ottenuto, come quello della formula di Dawes, rappresenta un punto di riferimento alle lunghezze d’onda visibili e non un numero da rispettare in modo rigoroso. Scostamenti del 10-20% sono ancora accettabili e, anzi, incoraggiati, poiché ogni sensore, telescopio e soggetto possono preferire valori leggermente diversi dalla semplice teoria con cui abbiamo ottenuto questi.

I valori che raggiungiamo sono tutti piuttosto piccoli ed ecco spiegato il motivo per cui nell’imaging planetario è preferibile usare sensori con pixel di dimensioni ridotte, tra i 3 e i 7 micron al massimo: l’opposto di quanto si preferisce fare nella fotografia a lunga esposizione.

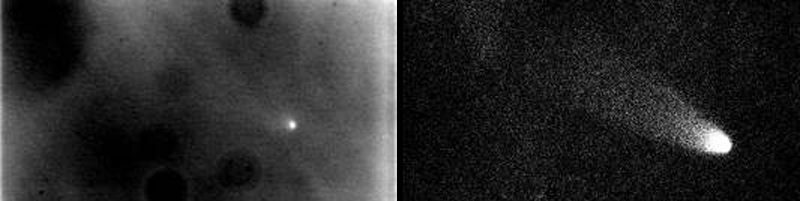

Nonostante questo, i rapporti focale tipici si aggirano tra f20-22 (per pixel da 3,7 micron) e f 30-35 (per pixel da 5,6 micron) e si rende necessario inserire oculari o lenti di Barlow per aumentare la focale nativa del telescopio. Invece di fare complicati calcoli sul rapporto focale raggiunto con un certo oculare o Barlow, per capire a quale campionamento reale si sta operando il modo migliore è fare dei test riprendendo un pianeta, ad esempio Giove. Misurando l’estensione in pixel e confrontandola con il diametro apparente che si può leggere da ogni software di simulazione del cielo, possiamo trovare il campionamento reale della ripresa applicando questa formula:

Ccalc = dang/dlin

Dove dang sono le dimensioni angolari (in secondi d’arco) e dlin il diametro misurato dell’immagine, espresso in pixel. Il campionamento restituito sarà in secondi d’arco su pixel. A questo punto la focale con cui è stata fatta la ripresa sarà:

Feq = (Dp/ C) x 206265

Dove Dp sono le dimensioni dei pixel del sensore, espresse in millimetri e C il campionamento (calcolato sull’immagine o stimato, non cambia). La focale restituita sarà in millimetri. Il rapporto focale sarà dato dalla semplice relazione Feq / D, con D = diametro del telescopio, in millimetri. Queste formule sono valide in generale, quindi anche per le riprese del profondo cielo.

Anche in questa circostanza, avere a disposizione miliardi di pixel è dannoso, e molto più rispetto alla fotografia del profondo cielo (in cui il danno principale è l’esigenza di avere telescopi dall’enorme capo corretto, quindi molto costosi). Poiché il campionamento ideale è fissato e i pianeti hanno dimensioni angolari ridotte, per ottenere ottime immagini non potremo avere, ad esempio, Giove esteso per 4 milioni di pixel. Il sovracampionamento nell’imaging in alta risoluzione è distruttivo e sarebbe sempre da evitare, molto più che nella fotografia a lunga esposizione nella quale, almeno, possiamo sperare di allungare il tempo di integrazione per sopperire in parte al danno che abbiamo fatto.

Nella fotografia in alta risoluzione “ingrandire” troppo l’immagine ci allontanerà sempre da un risultato ottimo. Anche se all’inizio potrebbe sembrare che ottenere delle “pizze” ingrandite a dismisura possa essere entusiasmante, in barba ai teorici del campionamento ideale, stiamo osservando un risultato che è sempre peggiore rispetto a quanto avremmo ottenuto con “l’ingrandimento” giusto. Non è un’opinione, è un fatto e anche se non piace non si può cambiare.

Se i pianeti saranno estesi al massimo qualche centinaio di pixel (se abbiamo strumenti oltre i 20 cm), che ce ne facciamo di un sensore che ne possiede diversi milioni? Niente, a meno che non ci vogliamo dedicare espressamente a panorami lunari, ma anche in queste circostanze ci sono comunque dei limiti. Usare sensori con più di 2-3 milioni di pixel per fare imaging in alta risoluzione non è una buona soluzione perché si riduce di molto il framerate, cioè la frequenza con cui si acquisiscono le immagini, che in alta risoluzione è fondamentale avere almeno a 15-20 frame al secondo (fps).